Внедрение AI-ассистентов в финансовых учреждениях, таких как банки и финтех-компании, значительно изменяет рабочие процессы. Это одно из самых преобразующих изменений за последние десятилетия. Переходя от пилотных проектов к широкомасштабным внедрениям, компаниям необходимо убедиться, что эти инструменты действительно добавляют ценность, а не создают дополнительные проблемы.

Важность интеграции команд

Компания Synechron понимает это как никто другой. Я работаю с командами, помогающими тысячам людей в финансовой сфере настраивать и работать вместе с AI-ассистентами. Это большое изменение, и не стоит ожидать, что все смогут адаптироваться мгновенно. Опыт показал, что обучение, проводимое командой экспертов по AI, интегрированных с бизнес-командами, критически важно для понимания возможностей и ограничений этих инструментов, а также для обеспечения их безопасности. Именно поэтому многие организации обращаются к проверенным сторонним поставщикам, так как не имеют такого опыта внутри компании.

Определение надежной информации

Для обеспечения безопасности необходимо выходить за рамки обычных отказов от ответственности в поисковых запросах AI. Организации должны определить, какая информация является надежной. Это включает обучение сотрудников о разнице между защищенными внутренними базами данных и источниками из интернета, а также о необходимости проверки фактов для минимизации рисков «галлюцинации» модели и осведомленности об этических и регуляторных вопросах. Особенно важно для финансовых фирм работать в контролируемых условиях при работе с конфиденциальными и чувствительными данными.

С точки зрения безопасности и конфиденциальности, существуют обоснованные опасения относительно использования генеративных AI-инструментов на рабочем месте. Как и при переходе на облачные сервисы, необходимо гарантировать безопасность данных при передаче и хранении. Компании должны точно знать, куда идут их данные – в защищенное облако или в открытые системы, такие как ChatGPT. Недостаток прозрачности в том, как данные обрабатываются и используются такими «черными ящиками» AI-моделей, вызывает озабоченность у многих организаций.

Некоторые инструменты просто не подходят для корпоративного использования, когда речь идет о конфиденциальной информации. ChatGPT рассчитан на массовое потребление и может не обеспечивать уровень безопасности и конфиденциальности, требуемый корпоративными системами. Например, GitHub Copilot генерирует код в IDE на основе запросов пользователя, что может случайно привести к уязвимостям, если этот код будет использоваться без проверки.

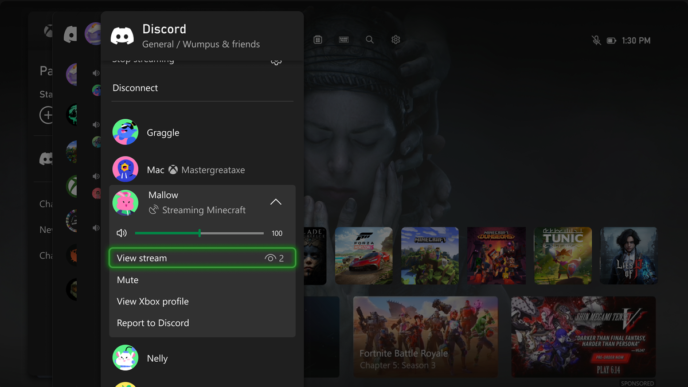

С интеграцией AI в операционные системы и инструменты повышения производительности эти проблемы могут только усугубиться. Новая функция Microsoft, Recall, фиксирует скриншоты всех действий пользователя и создает доступную для поиска временную линию, вызывая обеспокоенность по поводу чрезмерного наблюдения и возможного злоупотребления данными злонамеренными лицами. Отделы по соблюдению нормативных требований должны сопоставлять эти технологические функции с требованиями регуляторов по отчетности и сбору данных.

Защищенные изолированные среды

По мере расширения возможностей AI и их большей автономности, мы рискуем передать критически важные решения, касающиеся конфиденциальности и прав пользователей, этим системам. Хорошей новостью является то, что проверенные облачные провайдеры, такие как Azure, AWS и GCP, предлагают защищенные изолированные среды для безопасного развертывания AI-моделей с интеграцией корпоративной аутентификации. Компании также могут использовать крупные языковые модели на собственных серверах, за своим фаерволом, и применять открытые модели, чтобы точно понимать, какие данные использовались при обучении модели.

Прозрачность повышает доверие

В конечном счете, прозрачность моделей AI играет ключевую роль в повышении доверия и их принятии. Пользователи имеют право знать, как их данные обрабатываются, и иметь возможность выбора об участии. Конфиденциальность должна быть основным принципом с самого начала разработки, а не запоздалым решением. Строгое управление AI и тщательная проверка моделей также важны для обеспечения безопасности и эффективности систем по мере их быстрого развития.

Наконец, организации должны проводить регулярные проверки производительности – так же, как для любого сотрудника. Если AI-ассистент рассматривается как еще один коллега, должно быть ясно, что он приносит пользу, соответствующую (или превышающую) свои затраты на обучение и эксплуатацию. Важно помнить, что просто «интеграция AI» в компанию сама по себе не является ценностью.

Мы считаем, что эти инструменты будут жизненно важны и станут частью жизни большинства людей в ближайшем будущем. Главное, чтобы компании не думали, что могут просто предоставить доступ к инструментам и забыть о них; нельзя просто объявить об этом акционерам и надеяться на полную оперативность в течение квартала. Образование и обучение будут продолжительным процессом, и правильные меры безопасности, конфиденциальности и соблюдения нормативных требований необходимы для того, чтобы воспользоваться этими возможностями с уверенностью и гарантией безопасности.

Источник: TechRadar

Добавить комментарий

Ваш адрес email не будет опубликован.