Для дальнейшего развития генеративных моделей ИИ им необходимы высококачественные данные, созданные человеком. Ученые утверждают, что использование контента, сгенерированного ИИ, приводит к порче результата.

Исследователи из Кембриджского университета обнаружили, что каннибалистический подход к обучению ИИ быстро приводит к созданию бессмысленного контента, ставя под угрозу дальнейшее развитие технологий.

Команда использовала математический анализ, чтобы показать проблему, которая касается крупных языковых моделей (LLM), таких как ChatGPT, а также генераторов изображений, таких как Midjourney и DALL-E.

В опубликованном исследовании дается пример создания LLM для написания статей, похожих на статьи в Википедии.

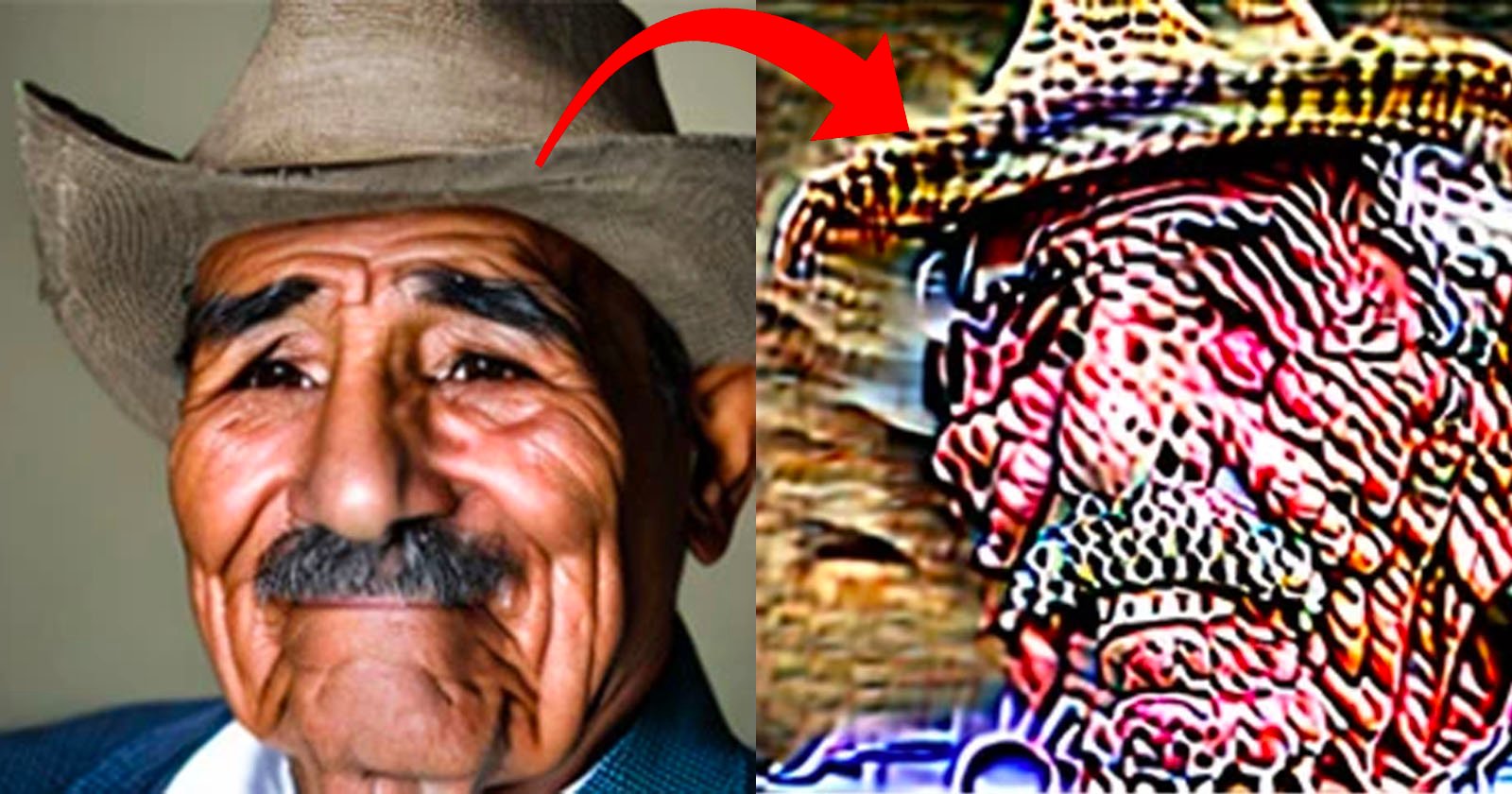

Исследователи сообщают, что они неоднократно обучали новые итерации модели на текстах, созданных предшественниками. По мере того как синтетические данные загрязняли обучающий набор, выходные данные модели становились бессмысленными.

Например, в статье об английских церковных башнях модель добавила много информации о зайцах. Хотя этот пример является крайним, любой ИИ-контент может вызвать сбои в моделях.

«Мы должны очень внимательно относиться к тому, какие данные попадают в наши обучающие наборы», — говорит соавтор Закар Шумайлов, исследователь ИИ из Кембриджского университета. «В противном случае все, скорее всего, пойдет наперекосяк».

Команда была удивлена, как быстро возникают проблемы при использовании контента, сгенерированного ИИ, в качестве обучающих данных.

Хани Фарид, компьютерный ученый из Калифорнийского университета в Беркли, который продемонстрировал аналогичный эффект на моделях изображений, сравнивает эту проблему с инбридингом у видов. «Если вид размножается внутри одной популяции, не разнообразя генофонд, это может привести к их вымиранию», — объясняет Фарид.

Шумайлов прогнозирует, что этот технологический нюанс приведет к росту затрат на создание моделей ИИ, поскольку увеличится стоимость качественных данных.

Еще одна проблема для компаний, работающих с ИИ, заключается в том, что контент, размещенный в открытом интернете, из которого они чаще всего черпают данные, постепенно заполняется синтетическими данными, что требует пересмотра их подходов к обучению.

При этом немногие правообладатели будут сожалеть о проблемах, с которыми сталкиваются компании, занимающиеся ИИ. Художники, фотографы и создатели контента из разных областей выражают сильное недовольство использованием их работ для обучения моделей ИИ.

Фото: M. Boháček & H. Farid/arXiv (CC BY 4.0)

Источник: PetaPixel

Добавить комментарий

Ваш адрес email не будет опубликован.