Конечно. Вот переписанная версия статьи:

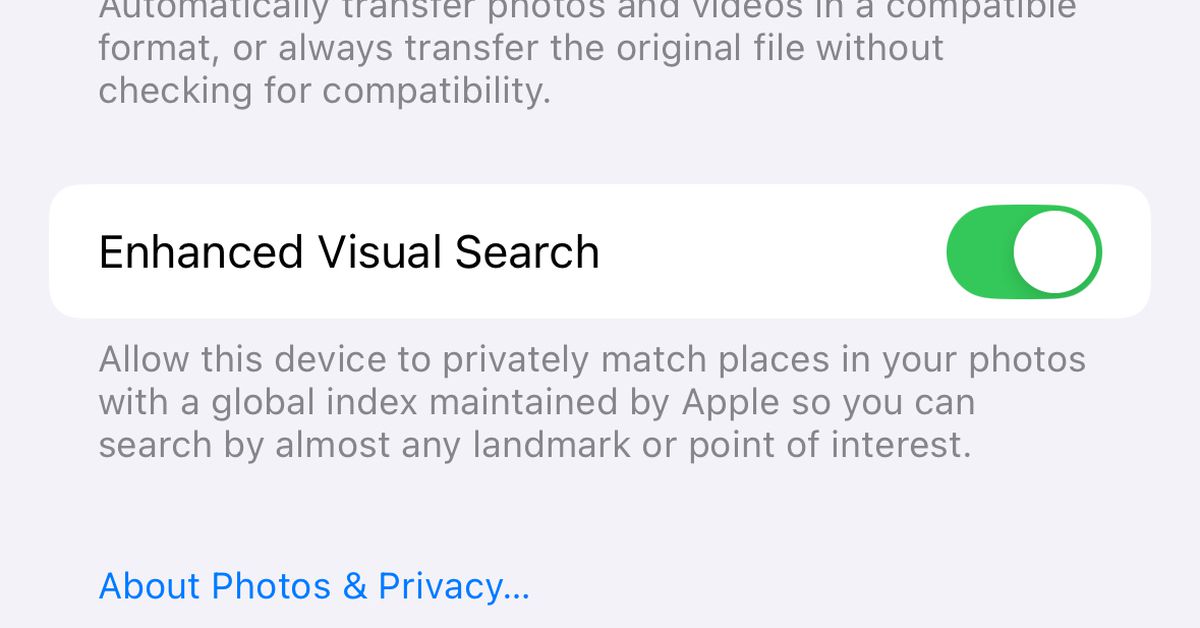

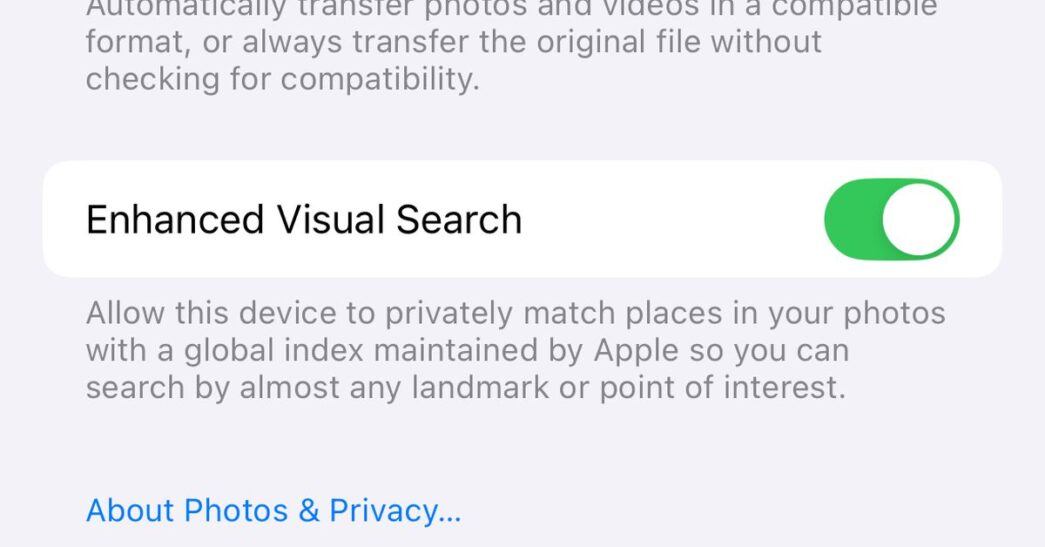

Утром, проверив свой iPhone 15 Pro, я заметил, что переключатель для функции Enhanced Visual Search уже был активирован. Вы можете найти этот переключатель в настройках Фото на вашем телефоне (через приложение Настройки iOS) или на Mac (в меню настроек приложения Фото). Эта функция позволяет искать достопримечательности, которые вы сфотографировали, или использовать их названия для поиска изображений.

Чтобы увидеть, что именно эта функция делает в приложении Фото, проведите по экрану вверх на фотографии здания и выберите «Искать достопримечательность». Откроется информация, которая, как предполагается, определяет объект на изображении. Вот несколько примеров с моего телефона:

Это, без сомнения, Кафедральный собор Святой Марии в Остине, а изображение справа — это не траппистский монастырь, а здание городской ратуши в Дюбьюке, Айова.

На первый взгляд, это удобное расширение функции Visual Look Up, которую Apple представила в iOS 15. Она позволяет идентифицировать растения или, например, расшифровать символы на этикетке одежды. Однако для использования Visual Look Up не требуется специального разрешения на обмен данными с Apple, тогда как для Enhanced Visual Search это необходимо.

Под переключателем указано, что вы даете Apple разрешение «в частном порядке сопоставлять места на ваших фотографиях с глобальным индексом, поддерживаемым Apple». Как именно это работает, описано в блоге по исследованию машинного обучения Apple, на который ссылается Джонсон:

Процесс начинается с локальной модели машинного обучения, которая анализирует данное фото, чтобы определить, есть ли на нем «область интереса», содержащая достопримечательность. Если модель определяет такую область в категории «достопримечательность», вычисляется векторное представление для этой части изображения.

Согласно блогу, это векторное представление затем шифруется и отправляется в Apple для сравнения с базой данных компании. Apple предоставляет очень техническое объяснение векторных представлений в одном из своих научных трудов, но IBM описывает это проще: векторные представления преобразуют «точку данных, такую как слово, предложение или изображение, в n-мерный массив чисел, представляющих характеристики этой точки данных.»

Так же, как и Джонсон, я не до конца понимаю исследовательские блоги Apple, и Apple не сразу ответила на наш запрос о комментариях по поводу обеспокоенности Джонсона. Кажется, компания предприняла значительные усилия, чтобы сохранить конфиденциальность данных, частично преобразуя данные изображения в формат, удобочитаемый моделью машинного обучения.

Тем не менее, сделать этот переключатель включаемым по усмотрению пользователя, как в случае обмена аналитическими данными, записями или взаимодействиями с Siri, кажется более целесообразным, чем заставлять пользователей самостоятельно его обнаруживать.

Исправление от 29 декабря: В предыдущей версии этой статьи было неверно указано расположение переключателя Enhanced Visual Search. Он находится в Настройках iOS, под пунктом Программы > Телефон, и в Фото > Настройки в приложении Фото на macOS. Заголовок также был сделан более ясным.

Источник: TheVerge